La Inteligencia Artificial y sus aplicaciones más disruptivas en la actualidad (parte 3)

“La verdad os hará libres; la mentira os hará creyentes”: Pepe Rodríguez (filósofo, psicólogo y escritor español)

🖋 David Moisés Terán Pérez *

Buenos días estimadas(os) lectoras(es) de esta columna invitada. Como ya es nuestra costumbre, deseo que tengan un grandioso, feliz, productivo y extraordinario martes. En esta ocasión, continuaremos desarrollando contenido para la saga que se inició hace ya dos semanas, con un tema bastante interesante y sumamente actualizado: “La Inteligencia Artificial (IA)”. Comenzamos: En esta ocasión, continuaremos con la explicación del funcionamiento de los modelos generativos sobre datos, para generar video a través de éstos; es decir, continuaremos explicando el formato de operación de SoraAI™, y también continuaremos ofreciendo un estado del arte o estado del conocimiento sobre este tema, a través de las referencias que se incluyen:

RED DE COMPRESIÓN DE VÍDEO

SoraAI™, entrena una red que reduce la dimensionalidad de los datos visuales [(Kingma & Welling, 2013)] Esta red toma video sin procesar como entrada, y genera una representación latente que se comprime tanto temporal, como espacialmente. SoraAI™, se entrena, y posteriormente genera videos dentro de este espacio latente comprimido. También se entrena un modelo decodificador correspondiente, que asigna las acciones latentes generadas, al espacio de píxeles.

PARCHES LATENTES DEL ESPACIO-TIEMPO: En SoraAI™, dado un vídeo de entrada comprimido, se extrae una secuencia de parches de espacio-tiempo que actúan como fichas (tokens) transformadoras. Este esquema también funciona para imágenes, ya que las imágenes son sólo videos con un solo cuadro. Nuestra representación basada en parches, permite a SoraAI™, entrenar en videos e imágenes de resoluciones, de duraciones y de relaciones de aspecto totalmente variables. En el momento de la inferencia, es posible controlar el tamaño de los videos generados, organizando parches inicializados aleatoriamente en una cuadrícula de tamaño adecuado.

TRANSFORMADORES DE ESCALADO PARA GENERACIÓN DE VIDEO

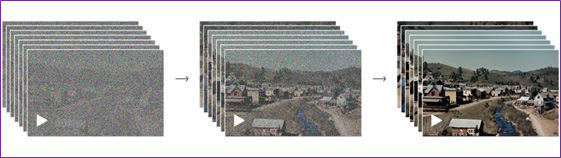

SoraAI™, es un modelo de difusión [(Ho; Jain & Abbeel, 2020); (Sohl-Dickstein, et. al., 2015); (Nichol & Dhariwal, 2021); (Dhariwal & Nichol, 2021); (Karras, et. al., 2022)]. Al recibir parches de entrada (e información condicionante como mensajes de texto), está entrenado para predecir los parches “limpios” originales (ver la Fig. 1). Es importante destacar que SoraAI™, es un transformador de difusión [(Peebles & Saining, 2023)]. Los transformadores de difusión, han demostrado notables propiedades de escala en una variedad de dominios, incluido el modelado del lenguaje [(Vaswani, et. al., 2017); (Brown, et. al., 2020)], la visión por computadora [(Dosovitskiy, et. al., 2020); (Arnab, et. al., 2021); (He, et. al., 2022); (Dehghani, et. al., 2023)], y la generación de imágenes [(Chen, et. al., 2020); (Ramesh, et. al., 2021); (Yu, et. al., 2022)].

En la Fig. 1, se puede visualizar que los transformadores de difusión, también se escalan efectivamente como modelos de video. La calidad de la muestra mejora notablemente, a medida que aumenta el cálculo en el entrenamiento de SoraAI™.

Fuente: https://openai.com/research/video-generation-models-as-world-simulators

DURACIONES, RESOLUCIONES Y RELACIONES DE ASPECTO VARIABLES

Los enfoques anteriores para la generación de imágenes y de videos, generalmente redimensionan, o recortan videos a un tamaño estándar; por ejemplo, videos de 4 segundos con una resolución de 256*256 pixeles. Se descubre que en cambio entrenar la aplicación con datos en su tamaño nativo, proporciona varios beneficios, por ejemplo, maximizar el uso de la memoria RAM durante la ejecución de la aplicación.

FLEXIBILIDAD DE MUESTREO

SoraAI™, puede muestrear videos de pantalla ancha de 1 920*1 080 pixeles, videos verticales de 1 080*1 920 pixeles, y todo lo demás. Esto permite a SoraAI™, crear contenido para diferentes dispositivos directamente en sus relaciones de aspecto nativas. También permite crear rápidamente prototipos de contenido en tamaños más pequeños, antes de generarlo a resolución completa, todo con el mismo modelo.

ENCUADRE Y COMPOSICIÓN MEJORADOS

Empíricamente, puede encontrarse que entrenar videos en sus proporciones nativas, mejora la composición y el encuadre. Si se compara a SoraAI™, con una versión del modelo que recorta todos los videos de entrenamiento, para que sean cuadrados, lo cual es una práctica común al entrenar modelos generativos. El modelo entrenado en cultivos cuadrados, muchas veces genera videos donde un sujeto y/o un objeto, solamente se ve(n) parcialmente. En comparación, los vídeos de SoraAI™, tienen un encuadre mejorado.

COMPRENSIÓN DEL LENGUAJE

Entrenar los sistemas de generación de texto para transformarlo a video, requiere de una ingente cantidad de videos con los subtítulos de texto correspondientes. Para ello, se aplica a los vídeos la técnica de re-subtitulado, introducida en DALL E-3 (Betker, et. al., 2023). Primero, se entrena un modelo de subtítulos altamente descriptivo, y luego se usa para producir subtítulos de texto para todos los videos en el conjunto de entrenamiento. Con la acción anterior, se descubrió que la formación sobre subtítulos de vídeo altamente descriptivos, mejora la fidelidad del texto, así como la calidad general de los vídeos. Al igual que en DALL E-3, también se aprovecha GPT para convertir breves mensajes de usuario en subtítulos más largos y detallados que se envían al modelo de vídeo. Esto permite a SoraAI™, generar vídeos de alta calidad que siguen con precisión las indicaciones del usuario. A continuación, se explica más a detalle, el contenido de este párrafo, ya que es la esencia que explica el funcionamiento de SoraAI™; así como algunos ejemplos de su uso en la cotidianidad:

- Comprensión del lenguaje: Se refiere al proceso de entrenar sistemas de inteligencia artificial para comprender y generar texto de manera efectiva.

- Entrenar los sistemas de generación de texto para transformarlo a video: Este es el objetivo principal del proceso descrito, que implica entrenar modelos de IA para generar videos a partir de texto.

- Re-subtitulado: Es una técnica que implica volver a generar subtítulos para videos existentes. En este contexto, se utiliza para generar una gran cantidad de subtítulos de texto para videos que se utilizarán en el proceso de entrenamiento.

- DALL E-3: Es el nombre de un sistema o modelo específico que introdujo esta técnica de re-subtitulado. DALL E-3 es una versión específica del modelo DALL E, posiblemente una versión mejorada o iteración del mismo.

- Modelo de subtítulos altamente descriptivo: Se refiere a un modelo de inteligencia artificial que ha sido entrenado para generar subtítulos de texto detallados y descriptivos para videos.

- Producción de subtítulos de texto para todos los videos en el conjunto de entrenamiento: Este es el paso, en el que se utilizan los modelos entrenados para generar subtítulos de texto para todos los videos en el conjunto de datos de entrenamiento.

- Mejora de la fidelidad del texto y la calidad general de los vídeos: Este es el resultado del proceso descrito, donde el uso de subtítulos de vídeo altamente descriptivos, mejora tanto la precisión del texto generado, como la calidad general de los videos producidos.

Y, para cerrar esta tercera entrega, se presentan algunos ejemplos de aplicación de DALL E-3 (herramienta de SoraAI™), en la cotidianidad:

- Generación de imágenes a partir de texto: DALL-E puede generar imágenes realistas a partir de descripciones de texto. Por ejemplo, si le das una descripción como “un gato hecho de helado”, DALL-E podría producir una imagen que cumpla con esa descripción.

- Edición de imágenes basada en texto: DALL-E puede utilizarse para realizar ediciones en imágenes basadas en descripciones de texto. Por ejemplo, podrías solicitar que cambie el color de un objeto en una imagen específica simplemente describiéndolo en palabras.

- Creación de arte generativo: Los artistas y diseñadores pueden usar DALL-E como herramienta creativa para generar ideas visuales a partir de conceptos escritos. Por ejemplo, podrían alimentar al modelo con descripciones abstractas y explorar las imágenes generadas como inspiración para proyectos artísticos.

- Ayuda en el diseño y la creación de contenido visual: DALL-E puede ser utilizado por diseñadores gráficos y creadores de contenido para generar rápidamente prototipos visuales o crear imágenes para ilustrar conceptos en presentaciones, publicaciones en redes sociales, blogs, etcétera.

La próxima semana, continuaremos desarrollando contenido para esta disruptiva herramienta. Ojalá que ustedes lectores(as), ya hayan tenido la oportunidad de descargar la herramienta SoraAI™ a sus equipos (computadora de escritorio, computadora portátil y tableta), para que comiencen a generar sus primeros videos a través de escribir textos, y de esa manera, aprendan y aprovechen esta herramienta, ya sea para su trabajo, para sus clases, o simplemente, para el entretenimiento. La descarga la pueden realizar con toda confianza, desde el siguiente sitio web: https://www.soradownload.com/es/ Muchas gracias, y saludos cordiales desde la por siempre sumamente Hermosa Bahía de Banderas (Puerto Vallarta y la Riviera Nayarit). (Continuará…)

Referencias:

Arnab, Anurag, et. al., (2021). Vivit: A video vision transformer. Proceedings of the IEEE/CVF International Conference on Computer Vision.

Betker, James, et. al., (2023). Improving image generation with better captions. Computer Science. Disponible en: https://cdn.openai.com/papers/dall-e-3, pdf. 2.3: 8.

Brown, Tom, et. al., (2020). Language models are few-shot learners. Advances in Neural Information Processing Systems, 33: p.p. 1 877-1 901.

Chen, Mark, et. al., (2020). Generative pretraining from pixels. International Conference on Machine Learning. PMLR.

Dehghani, Mostafa, et. al., (2023). Patch n’pack: NaViT, a vision transformer for any aspect ratio and resolution. arXiv preprint arXiv:2307.06304.

Dhariwal, Prafulla & Alexander Quinn Nichol. (2021). Diffusion Models Beat GAN on Image Synthesis. Advances in Neural Information Processing Systems.

Dosovitskiy, Alexey, et. al., (2020). An image is worth 16*16 words: Transformers for image recognition at scale. arXiv preprint arXiv:2010.11929.

He, Kaiming, et. al., (2022). Masked autoencoders are scalable vision learners. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition.

Ho, Jonathan; Ajay Jain, & Pieter Abbeel. (2020). Denoising diffusion probabilistic models. Advances in neural information processing systems 33: p.p. 6 840-6 851.

Karras, Tero, et. al., (2022). Elucidating the design space of diffusion-based generative models. Advances in Neural Information Processing Systems 35: 26565-26577.

Kingma, Diederik P., & Max Welling. (2013). Auto-encoding variational Bayes. arXiv preprint arXiv:1312.6114.

Meng, Chenlin, et. al., (2021). Sdedit: Guided image synthesis and editing with stochastic differential equations. arXiv preprint arXiv:2108.01073.

Nichol, Alexander Quinn & Prafulla Dhariwal. (2021). Improved denoising diffusion probabilistic models. International Conference on Machine Learning. PMLR.

Peebles, William & Saining Xie. (2023). Scalable diffusion models with transformers. Proceedings of the IEEE/CVF International Conference on Computer Vision.

Ramesh, Aditya, et. al., (2021). Zero-shot text-to-image generation. International Conference on Machine Learning. PMLR.

Ramesh, Aditya, et. al., (2022). Hierarchical text-conditional image generation with clip latents. arXiv preprint arXiv:2204.06125. 1.2: 3.

Sohl-Dickstein, Jascha, et. al., (2015). Deep unsupervised learning using nonequilibrium thermodynamics. International Conference on Machine Learning. PMLR.

Vaswani, Ashish, et. al., (2017). Attention is all you need. Advances in Neural Information Processing Systems, 30.

Yu, Jiahui, et. al., (2022). Scaling autoregressive models for content-rich text-to-image generation. arXiv preprint arXiv:2206.10789. 2.3: 5.